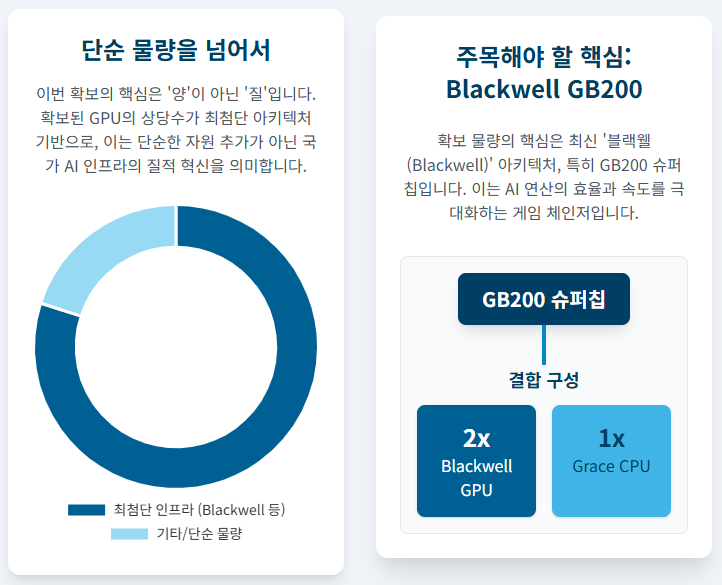

한국이 엔비디아로부터 확보한 GPU 26만장은 단순한 물량이 아니라, **최첨단 AI 반도체 인프라**를 의미합니다.

특히 이 물량의 상당수가 최신 블랙웰(Blackwell) 아키텍처 기반, 그중에서도 **GB200**과 같은 고성능 칩으로 추정되면서 기술적 파급력에 이목이 집중됩니다.

이번 대규모 GPU 확보가 대한민국 AI 기술 생태계에 던지는 실질적인 기술적 의미를 심층 분석해 드립니다.

📰 목차: 블랙웰 GPU의 기술 파급력

이 GPU 확보 이슈의 종합적인 배경과 국가적 전망은 메인 글(721)에서 확인하실 수 있습니다.

1. 블랙웰 아키텍처(GB200)의 혁신성: 왜 '게임 체인저'인가?

1-1. GB200 슈퍼칩: LLM 성능의 획기적 개선

블랙웰 아키텍처의 핵심인 **GB200(Grace Blackwell Superchip)**은 이전 세대인 호퍼(Hopper) 대비 연산 효율을 크게 높여 대규모 언어 모델(LLM) 학습과 추론에 최적화되었습니다. 엔비디아는 GB200이 최대 30배의 성능 향상을 가져올 수 있다고 강조합니다.

이는 한국 기업들이 자체 초거대 AI 모델을 개발하는 데 필요한 시간과 비용을 획기적으로 줄여줄 핵심 자산입니다.

1-2. 데이터 센터 전력 효율 개선

AI 인프라의 또 다른 난제는 막대한 전력 소모입니다. 블랙웰은 이전 아키텍처 대비 전력 효율을 개선하여, AI 데이터 센터 운영 비용과 환경 부하를 낮추는 데 기여합니다. 26만 장 규모의 인프라에서 이 효율성은 국가 단위의 경제성으로 직결됩니다.

2. HBM(고대역폭메모리)과 삼성/SK의 역할 증대

GPU 성능의 최종 열쇠, HBM

GPU 성능의 최대 병목 현상을 해소하는 것은 바로 **HBM(High Bandwidth Memory)**입니다. GPU 옆에 쌓아 올려 데이터 전송 속도를 극대화하는 HBM은 한국의 삼성전자와 SK하이닉스가 세계 시장을 주도하고 있습니다.

26만 장이라는 대규모 GPU 확보는 필연적으로 HBM3E, HBM4 등의 수요 확대로 이어지며, 이는 국내 메모리 반도체 기업들의 공급 규모와 협상력을 더욱 강화할 것입니다.

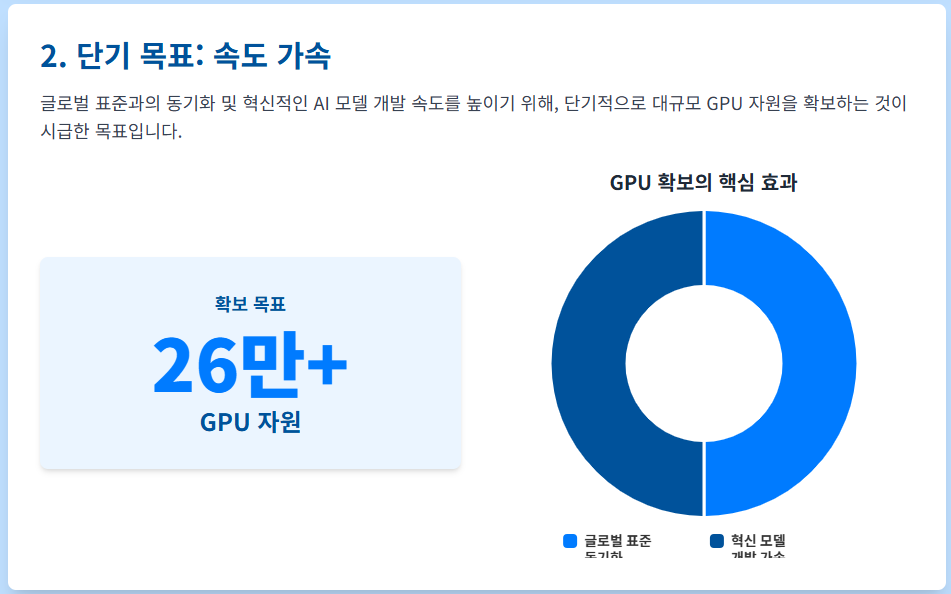

3. CUDA 생태계 심화와 한국 AI 개발 가속

기술 표준을 장악한 CUDA의 위력

GPU 하드웨어 그 자체보다 더 강력한 무기는 엔비디아의 소프트웨어 플랫폼인 **CUDA**입니다. 전 세계 AI 개발자들이 CUDA 환경에 익숙해져 있으며, 사실상 AI 개발의 표준으로 자리 잡았습니다.

26만 장의 GPU 확보는 국내 개발 환경을 글로벌 표준과 동기화시키고, 혁신적인 AI 모델을 개발하는 속도를 더욱 가속화할 것입니다.

기술 확보 이후, 한국형 MPU의 과제

단기적으로는 GPU 확보가 시급했지만, 장기적으로는 엔비디아 독점 구조를 벗어나기 위한 한국형 MPU(AI 반도체) 개발이 중요합니다. 정부는 이 부분을 별도의 정책 과제로 추진 중입니다.